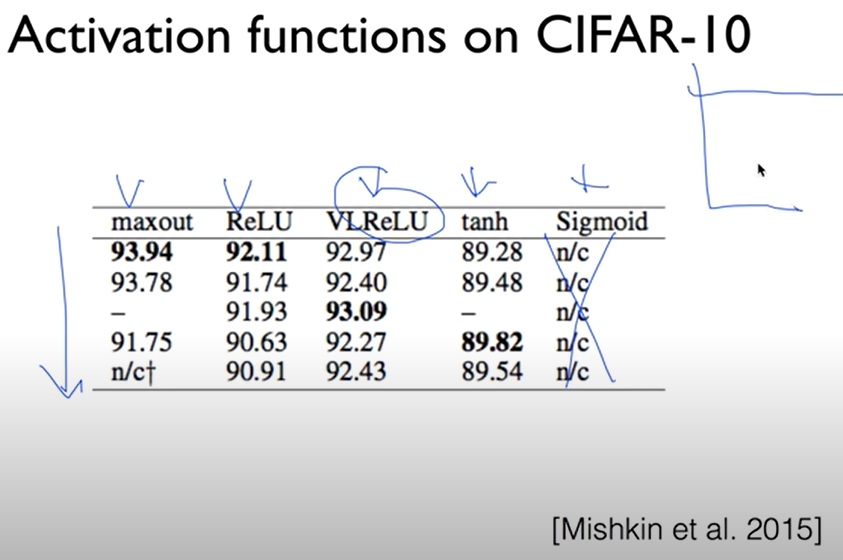

lec10-1: Sigmoid 보다 ReLU가 더 좋아

1단계: 배경 딥하게 다중 레이어를 쌓는 방법을 보자

NN = 인간의 신경망을 모방한 네트워크이다. 아래는 사전에 필요한 개념정리이다.

> Activation function은 ?

> 딥하게 한다는것은 활성화 함수가 있으므로 깊게 처리를 한다는것이다.

- 개념 : https://aidalab.tistory.com/17

- 종류 : http://blog.naver.com/PostView.nhn?blogId=wideeyed&logNo=221017173808

이개념하에 딥하게 확장 하는 방법을 살펴본다.

#. 시그모이드 함수 : https://icim.nims.re.kr/post/easyMath/64

적재 시키는 방법은

다단의 경우가 진행하면 문제가 발생한다.

원인 분석을 해보자.

결론 : 앞단의 값들이 작은값으로 수렴 되면서 문제의 원인이 발생 한다.= 경사도가 사라진다.

이문제로 NN의 문제가 발생으로 더이상 연구가 진행되지 않는다.

해결책은

Sigmod의 문제를 개선한다. 방법은 ReLU를 이용하는 것이다.

NN에서는 sigmoid를 이용하지 않고 , ReLU를 적용한다.

'4Z1 - Artificial Intelligence > 인공지능 개론' 카테고리의 다른 글

| Neural Network 2 - Dropout 과 앙상블 (0) | 2020.08.28 |

|---|---|

| Neural Network 2: ReLU and 초기값 정하기 (2006/2007 breakthrough) - Weight 초기화 (0) | 2020.08.28 |

| Neural Network 2: ReLU and 초기값 정하기 (2006/2007 breakthrough) - ReLU (0) | 2020.08.28 |

| 딥러닝 시작하기 요약 (0) | 2020.08.28 |

| Backpropagation -XOR (0) | 2020.08.27 |